- QUANTIQUE (MÉCANIQUE) - Propriétés fondamentales

- QUANTIQUE (MÉCANIQUE) - Propriétés fondamentalesLa mécanique quantique est aujourd’hui une théorie parfaitement «classique», dont la cohérence n’a fait que se renforcer au cours des cinquante dernières années. Après un laborieux enfantement au début du XXe siècle, elle accède à la maturité dans les années vingt. Bien qu’elle ait essentiellement reposé dans son élaboration sur les problèmes soulevés par la physique atomique, la mécanique quantique, une fois constituée en cadre théorique général, témoigne d’une fécondité extraordinaire dans les domaines voisins de la physique atomique et moléculaire, investit la chimie théorique, envahit la physique de l’état solide et des milieux condensés, et garde son empire sur les nouvelles branches de la microphysique: physique nucléaire d’abord, puis physique des particules fondamentales. Son hégémonie est restée à l’heure actuelle incontestée. Même si la mise en jeu des concepts fondamentaux de la théorie quantique se révèle parfois délicate et quelquefois même d’une extrême difficulté (par exemple en physique des particules), aucune indication expérimentale ne permet d’incriminer la validité même de ces concepts. Au contraire, la théorie quantique a remarquablement intégré certains développements tout à fait inattendus, comme la découverte de la non-conservation de la parité. Cette longue histoire d’un demi-siècle (cf. les articles BOHR, BROGLIE, DIRAC, HEISENBERG, PAULI, PLANCK, SCHRÖDINGER) a transformé le fragile, ésotérique et mystérieux corps de doctrine initial en une structure théorique robuste, aux solides assises expérimentales, qui constitue la référence commune de dizaines de milliers de chercheurs. Cette transformation radicale du statut de la physique quantique par la véritable pratique sociale dont elle est l’objet est cependant restée en général implicite. Son enseignement et sa vulgarisation n’ont pas, pendant longtemps, reflété cette transformation et ont pris un retard considérable. Loin d’utiliser d’emblée, pour élargir la compréhension et la connaissance des concepts quantiques, le riche matériau théorique et expérimental accumulé en plusieurs décennies, la plupart des exposés, cours ou livres ont suivi pas à pas le développement de la physique quantique. Cette méthode, beaucoup moins historique que chronologique (puisque toute histoire est nécessairement récurrente), a entraîné des pertes de temps considérables et répandu une confusion certaine. Il n’est pas interdit de voir ici les fâcheuses conséquences épistémologiques des tendances idéologiques dominantes telles qu’elles se sont marquées, dès les débuts de la physique quantique, dans le succès de philosophies de type positiviste. Cette interprétation est fondée sur l’absence quasi totale, dans le discours pédagogique usuel, de référence à la pratique massive qui sous-tend cette branche de la physique.Mais ces remarques mêmes, si elles conduisent à envisager une approche nouvelle, en marquent les limites. S’il est vrai, en effet, qu’on peut tenter aujourd’hui d’utiliser une déjà longue familiarité collective avec la physique quantique pour essayer d’en simplifier la présentation, dégageant les concepts essentiels et unifiant la structure de leurs relations réciproques, il est non moins vrai qu’aucun discours linéaire ne suffira à en donner une connaissance efficace. Si une certaine verbalisation préliminaire à la formalisation théorique (mathématique) est possible, cette dernière reste essentielle à toute compréhension réelle, puisqu’elle est la condition nécessaire de toute mise en pratique des lois physiques considérées, mise en pratique qui reste le critère ultime de la connaissance scientifique.Ces considérations, qui valent pour toute tentative de diffusion de connaissances scientifiques, prennent une importance particulière dans le cas de la mécanique quantique, par suite de la rupture que celle-ci implique avec un type de conceptualisation si familier qu’il semble s’identifier au «sens commun». Il est donc indispensable d’affirmer que cette rupture ne saurait être surmontée par une présentation faussement graduée qui masquerait la transition de la physique dite classique vers la physique quantique, sous la continuité chronologique par exemple. Les pseudo-paradoxes et difficultés résultant de la description des concepts et lois quantiques ne peuvent en aucun cas être levés par un raffinement de l’exposé ou par une vulgarisation plus détaillée. Tout au plus, le discours pédagogique peut-il tenter de convaincre de sa cohérence interne. La conviction de sa validité ne peut découler de l’écoute ni de la lecture passive de ce discours, mais elle exige une mise en jeu active. Il s’agira donc ici seulement d’une mise en place générale de la physique quantique , portant moins sur le détail formel de son contenu que sur son architecture générale et ses relations avec la physique dite classique; on soulignera avant tout les ruptures et les différences, y compris lors de l’utilisation des indispensables analogies.On précisera enfin un point de terminologie: l’expression «physique quantique» est ici utilisée pour désigner les divers domaines de la physique, théorique et expérimentale, qui reposent sur les lois et concepts de la «mécanique quantique». Ce terme (on dira aussi parfois «la théorie quantique») désigne l’ensemble de la structure théorique générale commune à ces domaines, indépendamment de leurs caractéristiques spécifiques. On se reportera, pour saisir ce point, au bilan détaillé des applications (mieux vaudrait dire des réalisations) de la mécanique quantique: physique atomique [cf. ATOME], physique moléculaire, physique des solides (cf. physique du SOLIDE), physique nucléaire [cf. NOYAU ATOMIQUE], physique des particules (cf. PARTICULES ÉLÉMENTAIRES, théorie des CHAMPS), etc.1. Les particules quantiques: ondes et/ou corpuscules?La physique classique (préquantique) connaît essentiellement deux catégories d’objets: les corpuscules et les ondes. Les premiers sont des entités discrètes, localisées dans une région restreinte de l’espace, décrivant certaines trajectoires, possédant à tout instant une position et une vitesse déterminées. Liées à sa vitesse, l’énergie et la quantité de mouvement d’un corpuscule sont les concepts essentiels que fait intervenir leur dynamique. Quant aux ondes classiques, elles décrivent des phénomènes non localisés, continus et occupant tout l’espace. Elles se superposent, donnant ainsi lieu à des interférences. Tout phénomène ondulatoire se décrit commodément comme une superposition d’ondes périodiques, à la fois dans le temps et dans l’espace, et donc caractérisées par une longueur d’onde (période spatiale) et une période temporelle.La mécanique quantique a procédé à une remarquable unification de ces deux catégories. On l’introduira ici au moyen d’une expérience conceptuelle très simple. Soit un dispositif formé d’une source S, d’une paroi P percée de deux trous 1 et 2 (trous d’Young) et d’un écran récepteur E. Envisageons trois situations: S émet des corpuscules classiques, S émet des ondes classiques, S émet des particules quantiques.a ) La source S émet des corpuscules classiques . On imaginera, par exemple, une mitrailleuse, sur un trépied, tirant de façon désordonnée dans toutes les directions. La paroi blindée P arrête les balles qui ne peuvent passer que par les trous 1 et 2 (fig. 1 a). Supposons tout d’abord 1 seul ouvert; seules parviennent à l’écran les balles passées par 1, dont les points d’impact forment une tache alignée sur S1, quelque peu élargie par l’effet des bords du trou sur les balles tangentes. Un résultat analogue se produit si 2 seul est ouvert. Dans chacun de ces cas, les répartitions des balles sur l’écran sont représentées par deux courbes I1 et I2. Si les deux trous sont ouverts, on obtient une courbe de répartition qui n’est autre que la somme des courbes précédentes: I1,2 = I1 + I2. En effet, bien que ces courbes soient continues, puisqu’elles donnent le nombre moyen de balles arrivant en chaque point de l’écran, le phénomène est corpusculaire, donc discontinu; chaque balle passe soit par le trou 1, soit par le trou 2. Le nombre de balles arrivant en un point de l’écran est bien la somme du nombre des balles passées par l’un ou par l’autre des trous.b ) La source S émet des ondes classiques . Il s’agira par exemple d’une source sonore mettant l’air en vibration comme un haut-parleur. Un microphone se déplaçant sur l’écran E y mesurera l’intensité sonore (fig. 1 b). Supposons d’abord 1 seul ouvert; aux effets de diffraction par les bords près, le son ne parviendra sur l’écran que dans la zone située sur la ligne S1. Le résultat sera analogue si 2 seul est ouvert, de sorte que, dans ce cas, les intensités I1 et I2 ressemblent à celles du cas précédent. Mais, si l’on ouvre 1 et 2, on obtient un phénomène tout différent: l’intensité I1,2 présente des maximums et minimums successifs sur l’écran et n’est plus identique à la somme I1 + I2. En effet, l’onde sonore, non localisée, passe à la fois par les deux trous 1 et 2. L’amplitude de l’onde arrivant sur l’écran résulte donc de l’addition des amplitudes transmises par 1 et par 2. Comme, en général, les chemins parcourus depuis 1 et 2 diffèrent, les deux ondes sont décalées. Si la différence des chemins est d’une longueur d’onde (ou de deux, ou de trois, etc.), les ondes atteignent leur amplitude maximale en même temps et se renforcent (elles sont en phase). Si cette différence est d’une demi-longueur d’onde, les ondes ont des amplitudes exactement opposées, leurs effets se compensent et leur résultante est nulle (opposition de phase). L’intensité, qui est proportionnelle au carré de l’amplitude, sera maximale dans le premier cas, minimale (nulle) dans le second. Ces interférences sont liées à la continuité du phénomène ondulatoire qui se propage de la source à l’écran par l’un et l’autre des trous (au lieu du «ou » disjonctif du cas corpusculaire). En termes plus techniques, on introduit les amplitudes u 1 et u 2 des ondes partielles transmises par 1 et par 2. Les intensités I1 et I2 sont données par I1 = (u 1)2 et par I2 = (u 2)2. Quand les trous 1 et 2 sont ouverts, l’amplitude est u 1,2 = u 1 + u 2 (superposition des ondes) et l’intensité I1,2 = (u 1 + u 2)2 I1 + I2.c ) Utilisons maintenant une source lumineuse en S et une plaque photographique sur l’écran E. Si l’intensité de la source lumineuse est forte, le résultat est analogue au cas précédent: il y a interférence d’ondes lumineuses, ce qui se traduit expérimentalement par une alternance de plages sombres et de plages claires sur la plaque photographique [cf. INTERFÉRENCES LUMINEUSES]. Mais, si l’on diminue considérablement l’intensité de la source lumineuse (par exemple au moyen de filtres absorbants), on s’aperçoit que l’intensité lumineuse sur la plaque, loin d’être continue, résulte en fait d’une multitude d’impacts lumineux microscopiques. Le flux lumineux est en réalité discontinu et constitué d’entités individuelles: ce sont les photons. Ces photons arrivent donc un par un sur la plaque. Ils sont dénombrables comme des corpuscules classiques, mais présentent néanmoins des phénomènes d’interférences comme les ondes classiques: c’est le plus ou moins grand nombre de photons arrivant sur une zone donnée de la plaque qui rend compte de ces différences d’éclairement et donc de l’apparition de la figure d’interférences. On obtient des résultats analogues en faisant l’expérience avec des électrons. Dans ce cas, l’aspect corpusculaire évident se voit corrigé par l’apparition d’un phénomène d’interférences ondulatoire, que traduit la répartition des impacts successifs des électrons.On en conclut que photons et électrons ne sont assimilables ni aux corpuscules ni aux ondes de la mécanique classique. Ils présentent, et toutes les particules de la microphysique avec eux, des caractères à la fois spécifiques et universels: tous les micro-objets se comportent de même. En vérité, les concepts mêmes de corpuscule et d’onde ne sont que deux approximations, valables à l’échelle macroscopique et incompatibles entre elles, de la nature profonde et unique des constituants de la matière. Sans doute faudrait-il inventer un nouveau mot; quanton , parmi d’autres, a été proposé, pour désigner ces objets ni femme ni poisson: on parlera de particules quantiques en se souvenant qu’il ne s’agit ni de corpuscules ni d’ondes, mais que chacune de ces images peut être utile dans certaines conditions.Il reste à formaliser de façon cohérente ce comportement. L’existence même du phénomène d’interférences amène à introduire, comme dans le cas des ondes classiques, des amplitudes capables de s’ajouter. Ainsi, dans le cas de l’expérience des trous d’Young, l’arrivée des particules quantiques sur l’écran sera décrite par des amplitudes f 1(x ) ou f 2(x ), suivant que le trou 1 ou le trou 2 est seul ouvert, amplitudes qui dépendent évidemment de la position d’arrivée sur l’écran x à laquelle on s’intéresse. Comment interpréter les carrés de ces amplitudes qui donnaient les intensités du cas ondulatoire classique? Il n’y a pas ici d’intensités continues puisqu’il s’agit d’impacts individuels, discrets, des particules. C’est Max Born, en 1924, qui eut l’idée d’interpréter ces quantités comme les probabilités d’arrivée des particules: (f 1(x ))2 pour le trou 1. L’amplitude correspondant à l’ouverture des deux trous est la somme des deux amplitudes précédentes, f 1,2(x ) = f 1(x ) + f 2(x ); son carré donne la probabilité d’impact en x , et l’on voit qu’elle ne se réduit pas à la somme des probabilités correspondant à l’ouverture de chacun des trous.Cette description est générale: un processus quantique quelconque est décrit en termes d’amplitudes, appelées amplitudes de probabilité . Ce sont des nombres associés à un état initial (ici, émission de particules par la source) et à un état final donnés (ici, arrivée de la particule sur l’écran en x ) dans des conditions bien déterminées (ici, l’un, l’autre ou les deux trous ouverts). Leur carré donne la probabilité (ou, plus précisément ici, la densité de probabilité ) de réalisation de l’état final considéré à partir de l’état initial. La propriété essentielle de ces amplitudes de probabilité réside dans leur additivité : pour un état initial et un état final déterminés, l’amplitude correspondant à la conjonction de plusieurs éventualités intermédiaires (les deux trous ouverts) est la somme des amplitudes correspondant à chaque éventualité (l’un ou l’autre trou ouvert). Ce principe de superposition des amplitudes exclut évidemment l’additivité des probabilités elles-mêmes et il est la base des effets les plus notables de la mécanique quantique. La signification que l’on doit attribuer aux caractères probabilistes de la mécanique quantique sera étudiée plus loin (cf. chap. 5).Revenons sur la double apparence (classique) des particules (quantiques). Elle se traduit par deux formules fondamentales qui relient entre eux leurs aspects corpusculaires et ondulatoires. Comme les corpuscules classiques, les particules quantiques sont caractérisables par leur énergie E et par leur quantité de mouvement p . Comme les ondes classiques, elles peuvent être décrites à l’aide de leur fréquence temporelle 益 (l’inverse de la période: 益 = 1/T) et de leur fréquence spatiale, ou nombre d’ondes k (c’est l’inverse de la longueur d’onde: k = 1/, ou encore le nombre de longueurs d’onde comprises dans l’unité de longueur). On doit à Planck et à Einstein d’une part (1900-1905) et à de Broglie de l’autre (1924) d’avoir établi la proportionnalité de ces grandeurs, suivant les formules:

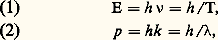

où h est une constante universelle appelée constante de Planck de valeur h = 6,6 憐 10 size=1漣34 dans le système d’unités M.K.S.A., c’est-à-dire en joules-secondes. En d’autres termes, toute particule à laquelle on pourrait attribuer une énergie et une quantité de mouvement bien déterminées (ce n’est pas toujours le cas!) peut être conçue de façon approchée comme un corpuscule ainsi caractérisé dans certaines conditions, ou comme une onde de fréquence connue.On citera comme premier exemple l’effet photoélectrique . Einstein a montré, en 1905, que l’impact d’un photon de fréquence 益 sur un métal suffisait à en extraire un électron si l’énergie du photon h 益 dépassait l’énergie d’extraction W nécessaire pour dégager l’électron du métal. L’électron émerge alors avec l’énergie E = h 益 漣 W. La vérification de la dépendance linéaire de E par rapport à 益 permet de confirmer la relation (1) et de mesurer la constante de Planck. De même l’effet Compton (1922), ou émission d’électrons sous l’effet de rayons X, s’interprète-t-il aisément (cf. effet COMPTON) comme une simple collision entre un électron, initialement quasi immobile dans un atome, et un photon caractérisé par les propriétés (1) et (2). En sens inverse, les propriétés ondulatoires d’électrons de vitesses bien déterminées ont été vérifiées après la célèbre prédiction de L. de Broglie (1924), lors des expériences de diffraction d’électrons par un réseau cristallin, par C. L. Davisson et L. H. Germer (1927).2. Les relations de Heisenberg ; heuristique quantiqueLes relations de Planck-Einstein (1) et de De Broglie (2) lient des propriétés de type corpusculaire (énergie et quantité de mouvement d’entités discrètes) à des propriétés de type ondulatoire (périodicités spatio-temporelles). Leur existence même implique donc l’inapplicabilité sans réserve des concepts de corpuscule ou d’onde aux particules quantiques. Plus précisément, elles permettent de cerner le domaine de validité approximative de ces concepts. C’est là l’un des rôles essentiels des fameuses relations de Heisenberg , dites encore relations d’incertitude .Si l’on considère une particule quantique qui occupe un domaine spatial d’extension x limité, la longueur d’onde (ou la fréquence spatiale k = 1/ qui lui est associée) ne peut être précisée de façon absolue. En effet, un phénomène de longueur d’onde bien déterminée est rigoureusement périodique et possède donc une extension spatiale infinie. Dans le cas présent, si la dimension x de l’objet correspond à un nombre de périodes approximatif n , la longueur d’onde moyenne sera donnée par = x /n et la fréquence spatiale par k = n / x . Mais le nombre de périodes n ne peut certainement pas être défini à mieux qu’une unité près, puisque le phénomène, n’étant pas rigoureusement périodique, a un début et une fin qui ne correspondent pas à des périodes qu’on puisse nettement distinguer. Il en résulte une extension k de la fréquence spatiale k , liée à l’incertitude n 礪黎 1 sur le nombre de périodes n , soit k 礪黎 1/ x , où k 練 x 礪黎 1. Jusqu’ici le raisonnement vaut pour tout phénomène ondulatoire et lie son extension en configuration (spatiale) x à son extension en fréquence (spatiale) k . Mais, si l’on confronte ce résultat à la relation de De Broglie (2), on voit qu’à une certaine extension en fréquence spatiale k correspond nécessairement une extension en quantité de mouvement p = h k . D’où la relation de Heisenberg:

où h est une constante universelle appelée constante de Planck de valeur h = 6,6 憐 10 size=1漣34 dans le système d’unités M.K.S.A., c’est-à-dire en joules-secondes. En d’autres termes, toute particule à laquelle on pourrait attribuer une énergie et une quantité de mouvement bien déterminées (ce n’est pas toujours le cas!) peut être conçue de façon approchée comme un corpuscule ainsi caractérisé dans certaines conditions, ou comme une onde de fréquence connue.On citera comme premier exemple l’effet photoélectrique . Einstein a montré, en 1905, que l’impact d’un photon de fréquence 益 sur un métal suffisait à en extraire un électron si l’énergie du photon h 益 dépassait l’énergie d’extraction W nécessaire pour dégager l’électron du métal. L’électron émerge alors avec l’énergie E = h 益 漣 W. La vérification de la dépendance linéaire de E par rapport à 益 permet de confirmer la relation (1) et de mesurer la constante de Planck. De même l’effet Compton (1922), ou émission d’électrons sous l’effet de rayons X, s’interprète-t-il aisément (cf. effet COMPTON) comme une simple collision entre un électron, initialement quasi immobile dans un atome, et un photon caractérisé par les propriétés (1) et (2). En sens inverse, les propriétés ondulatoires d’électrons de vitesses bien déterminées ont été vérifiées après la célèbre prédiction de L. de Broglie (1924), lors des expériences de diffraction d’électrons par un réseau cristallin, par C. L. Davisson et L. H. Germer (1927).2. Les relations de Heisenberg ; heuristique quantiqueLes relations de Planck-Einstein (1) et de De Broglie (2) lient des propriétés de type corpusculaire (énergie et quantité de mouvement d’entités discrètes) à des propriétés de type ondulatoire (périodicités spatio-temporelles). Leur existence même implique donc l’inapplicabilité sans réserve des concepts de corpuscule ou d’onde aux particules quantiques. Plus précisément, elles permettent de cerner le domaine de validité approximative de ces concepts. C’est là l’un des rôles essentiels des fameuses relations de Heisenberg , dites encore relations d’incertitude .Si l’on considère une particule quantique qui occupe un domaine spatial d’extension x limité, la longueur d’onde (ou la fréquence spatiale k = 1/ qui lui est associée) ne peut être précisée de façon absolue. En effet, un phénomène de longueur d’onde bien déterminée est rigoureusement périodique et possède donc une extension spatiale infinie. Dans le cas présent, si la dimension x de l’objet correspond à un nombre de périodes approximatif n , la longueur d’onde moyenne sera donnée par = x /n et la fréquence spatiale par k = n / x . Mais le nombre de périodes n ne peut certainement pas être défini à mieux qu’une unité près, puisque le phénomène, n’étant pas rigoureusement périodique, a un début et une fin qui ne correspondent pas à des périodes qu’on puisse nettement distinguer. Il en résulte une extension k de la fréquence spatiale k , liée à l’incertitude n 礪黎 1 sur le nombre de périodes n , soit k 礪黎 1/ x , où k 練 x 礪黎 1. Jusqu’ici le raisonnement vaut pour tout phénomène ondulatoire et lie son extension en configuration (spatiale) x à son extension en fréquence (spatiale) k . Mais, si l’on confronte ce résultat à la relation de De Broglie (2), on voit qu’à une certaine extension en fréquence spatiale k correspond nécessairement une extension en quantité de mouvement p = h k . D’où la relation de Heisenberg: Elle est ici conçue comme reliant l’extension spatiale x d’un objet quantique, sa «dimension géométrique», à la largeur du spectre p des valeurs de sa quantité de mouvement. Cette relation montre immédiatement qu’une particule quantique est inassimilable à un corpuscule classique, puisqu’un tel objet peut être simultanément localisé ponctuellement ( x = 0) et avoir une quantité de mouvement bien définie ( p = 0), c’est-à-dire obéir à l’égalité p 練 x = 0. En d’autres termes, les concepts mêmes de position (localisation) et de quantité de mouvement ne peuvent pas avoir, pour une particule quantique, strictement le même sens que pour un corpuscule classique, ce qui n’empêche pas ces concepts, une fois refondus au moule quantique, de garder toute leur importance.Une malheureuse tradition veut que les relations de Heisenberg reçoivent usuellement une interprétation assez différente, où x et p sont conçus comme des incertitudes sur les valeurs de la position et de la quantité de mouvement. La relation (3) est alors censée relier ces incertitudes de façon qu’elles ne puissent s’annuler toutes deux simultanément. On en conclut alors que la théorie quantique, et plus précisément la constante de Planck h , impose une limitation fondamentale à la précision des mesures physiques. Mais la terminologie même est ici lourde d’implications dangereuses: parler d’incertitudes sur la position et sur la quantité de mouvement, c’est automatiquement supposer qu’on veut connaître celles-ci exactement, donc qu’on prétend caractériser une particule quantique par les mêmes attributs qu’un corpuscule classique. C’est en fait l’illégitimité d’une telle prétention que sanctionne la relation (3). Si l’interprétation traditionnelle a des motivations historiques compréhensibles, sa persistance est plus troublante. En effet, lors de la naissance de la théorie quantique, il était parfaitement légitime et difficilement évitable d’utiliser au maximum la conceptualisation classique. Après un demi-siècle de pratique et l’établissement des concepts propres à la mécanique quantique, on ne comprend guère le maintien de l’interprétation primitive que comme manifestation du néopositivisme qui tient le rôle dominant en philosophie des sciences aujourd’hui.Loin d’ailleurs d’être un obstacle absolu à la précision des mesures et une limitation fondamentale de notre connaissance, les relations de Heisenberg offrent au contraire un moyen d’accès précieux à la compréhension de certains résultats de la mécanique quantique. Dans la mesure même où leur rôle fondamental est d’indiquer la limite de validité des concepts classiques, elles permettent de savoir «jusqu’où on peut aller trop loin» en utilisant ces derniers. Elles constituent ainsi un élément essentiel d’une féconde heuristique quantique largement utilisée (quoique parfois avec une singulière mauvaise conscience) par les physiciens.Un premier exemple d’application de la relation de Heisenberg est donné par la justification (technique, sinon sociale) de la course aux hautes énergies actuellement engagée en physique des particules et des interactions fondamentales. Le problème posé est celui d’une étude des lois de la physique à une échelle toujours plus petite. Or, pour étudier les phénomènes qui se déroulent dans une région de l’espace de dimensions inférieures à, mettons, x , il est nécessaire d’utiliser, comme sondes expérimentales, des objets (particules accélérées, ici) dont l’extension spatiale propre soit évidemment inférieure à la dimension x du domaine à explorer. D’après la relation de Heisenberg, cela exige que ces particules disposent d’un spectre de quantité de mouvement de largeur p 礪黎 h / x .Plus le domaine à explorer est petit, plus la quantité de mouvement maximale et donc l’énergie maximale de la particule doivent être grandes: d’où la nécessité d’accélérateurs de particules de plus en plus puissants (les accélérateurs actuels, qui communiquent aux particules des énergies de quelques centaines de milliards d’électrons-volts, rendent possible l’exploration des lois de la physique à l’échelle du millionième de milliardième de centimètre: 10 size=1漣15 cm).Un deuxième type d’application de la relation de Heisenberg concerne le problème fondamental de la physique atomique , celui-là même qui fut à l’origine des développements de la théorie quantique dans les années 1910-1925. Il s’agit d’expliquer la stabilité des atomes, c’est-à-dire l’existence d’un état d’énergie minimale. Classiquement, il existe, en effet, une gamme continue d’énergies possibles pour un système de charges électriques liées par les forces électrostatiques. Dans le cas le plus simple, celui de l’atome d’hydrogène, qui comprend un électron unique retenu par l’attraction coulombienne d’un proton, les orbites classiques de l’électron pourraient être aussi proches que l’on veut du proton, lui conférant des énergies potentielles négatives sans borne inférieure (les forces électrostatiques augmentent comme le carré de l’inverse de la distance entre les particules lorsque celles-ci se rapprochent, et l’énergie potentielle comme l’inverse de cette même distance). Mais on remarque que cette énergie potentielle, de plus en plus basse puisqu’elle correspond à des orbites électroniques de plus en plus petites, donc à une extension spatiale de plus en plus faible de l’électron, exige une extension en quantité de mouvement de plus en plus grande d’après la relation de Heisenberg et entraîne une valeur de plus en plus élevée pour la vitesse, donc pour l’énergie cinétique. L’énergie totale de l’électron comportant deux termes, l’énergie cinétique et l’énergie potentielle, qui varient en sens inverse, trouve ainsi la possibilité d’être bornée inférieurement dans la région où ni l’un ni l’autre des deux termes ne l’emporte considérablement sur l’autre. Ce raisonnement se formalise en écrivant l’énergie totale de l’électron sous sa forme classique:

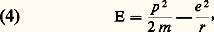

Elle est ici conçue comme reliant l’extension spatiale x d’un objet quantique, sa «dimension géométrique», à la largeur du spectre p des valeurs de sa quantité de mouvement. Cette relation montre immédiatement qu’une particule quantique est inassimilable à un corpuscule classique, puisqu’un tel objet peut être simultanément localisé ponctuellement ( x = 0) et avoir une quantité de mouvement bien définie ( p = 0), c’est-à-dire obéir à l’égalité p 練 x = 0. En d’autres termes, les concepts mêmes de position (localisation) et de quantité de mouvement ne peuvent pas avoir, pour une particule quantique, strictement le même sens que pour un corpuscule classique, ce qui n’empêche pas ces concepts, une fois refondus au moule quantique, de garder toute leur importance.Une malheureuse tradition veut que les relations de Heisenberg reçoivent usuellement une interprétation assez différente, où x et p sont conçus comme des incertitudes sur les valeurs de la position et de la quantité de mouvement. La relation (3) est alors censée relier ces incertitudes de façon qu’elles ne puissent s’annuler toutes deux simultanément. On en conclut alors que la théorie quantique, et plus précisément la constante de Planck h , impose une limitation fondamentale à la précision des mesures physiques. Mais la terminologie même est ici lourde d’implications dangereuses: parler d’incertitudes sur la position et sur la quantité de mouvement, c’est automatiquement supposer qu’on veut connaître celles-ci exactement, donc qu’on prétend caractériser une particule quantique par les mêmes attributs qu’un corpuscule classique. C’est en fait l’illégitimité d’une telle prétention que sanctionne la relation (3). Si l’interprétation traditionnelle a des motivations historiques compréhensibles, sa persistance est plus troublante. En effet, lors de la naissance de la théorie quantique, il était parfaitement légitime et difficilement évitable d’utiliser au maximum la conceptualisation classique. Après un demi-siècle de pratique et l’établissement des concepts propres à la mécanique quantique, on ne comprend guère le maintien de l’interprétation primitive que comme manifestation du néopositivisme qui tient le rôle dominant en philosophie des sciences aujourd’hui.Loin d’ailleurs d’être un obstacle absolu à la précision des mesures et une limitation fondamentale de notre connaissance, les relations de Heisenberg offrent au contraire un moyen d’accès précieux à la compréhension de certains résultats de la mécanique quantique. Dans la mesure même où leur rôle fondamental est d’indiquer la limite de validité des concepts classiques, elles permettent de savoir «jusqu’où on peut aller trop loin» en utilisant ces derniers. Elles constituent ainsi un élément essentiel d’une féconde heuristique quantique largement utilisée (quoique parfois avec une singulière mauvaise conscience) par les physiciens.Un premier exemple d’application de la relation de Heisenberg est donné par la justification (technique, sinon sociale) de la course aux hautes énergies actuellement engagée en physique des particules et des interactions fondamentales. Le problème posé est celui d’une étude des lois de la physique à une échelle toujours plus petite. Or, pour étudier les phénomènes qui se déroulent dans une région de l’espace de dimensions inférieures à, mettons, x , il est nécessaire d’utiliser, comme sondes expérimentales, des objets (particules accélérées, ici) dont l’extension spatiale propre soit évidemment inférieure à la dimension x du domaine à explorer. D’après la relation de Heisenberg, cela exige que ces particules disposent d’un spectre de quantité de mouvement de largeur p 礪黎 h / x .Plus le domaine à explorer est petit, plus la quantité de mouvement maximale et donc l’énergie maximale de la particule doivent être grandes: d’où la nécessité d’accélérateurs de particules de plus en plus puissants (les accélérateurs actuels, qui communiquent aux particules des énergies de quelques centaines de milliards d’électrons-volts, rendent possible l’exploration des lois de la physique à l’échelle du millionième de milliardième de centimètre: 10 size=1漣15 cm).Un deuxième type d’application de la relation de Heisenberg concerne le problème fondamental de la physique atomique , celui-là même qui fut à l’origine des développements de la théorie quantique dans les années 1910-1925. Il s’agit d’expliquer la stabilité des atomes, c’est-à-dire l’existence d’un état d’énergie minimale. Classiquement, il existe, en effet, une gamme continue d’énergies possibles pour un système de charges électriques liées par les forces électrostatiques. Dans le cas le plus simple, celui de l’atome d’hydrogène, qui comprend un électron unique retenu par l’attraction coulombienne d’un proton, les orbites classiques de l’électron pourraient être aussi proches que l’on veut du proton, lui conférant des énergies potentielles négatives sans borne inférieure (les forces électrostatiques augmentent comme le carré de l’inverse de la distance entre les particules lorsque celles-ci se rapprochent, et l’énergie potentielle comme l’inverse de cette même distance). Mais on remarque que cette énergie potentielle, de plus en plus basse puisqu’elle correspond à des orbites électroniques de plus en plus petites, donc à une extension spatiale de plus en plus faible de l’électron, exige une extension en quantité de mouvement de plus en plus grande d’après la relation de Heisenberg et entraîne une valeur de plus en plus élevée pour la vitesse, donc pour l’énergie cinétique. L’énergie totale de l’électron comportant deux termes, l’énergie cinétique et l’énergie potentielle, qui varient en sens inverse, trouve ainsi la possibilité d’être bornée inférieurement dans la région où ni l’un ni l’autre des deux termes ne l’emporte considérablement sur l’autre. Ce raisonnement se formalise en écrivant l’énergie totale de l’électron sous sa forme classique: où e et m sont la charge et la masse de l’électron, p sa quantité de mouvement et r sa distance au noyau; cette égalité est soumise à la contrainte de la relation de Heisenberg:

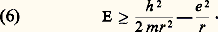

où e et m sont la charge et la masse de l’électron, p sa quantité de mouvement et r sa distance au noyau; cette égalité est soumise à la contrainte de la relation de Heisenberg: qui seule permet l’utilisation simultanée des concepts approximativement classiques de position (r ) et de quantité de mouvement (p ). Tenant compte de l’inégalité (5), l’énergie E totale obéit à l’inégalité:

qui seule permet l’utilisation simultanée des concepts approximativement classiques de position (r ) et de quantité de mouvement (p ). Tenant compte de l’inégalité (5), l’énergie E totale obéit à l’inégalité: Conformément aux prévisions, cette quantité, nulle lorsque l’électron est indéfiniment éloigné du noyau, décroît ensuite et devient négative lorsqu’il se rapproche, mais se remet à croître indéfiniment lorsqu’il s’approche de trop près (croissance de l’énergie cinétique due à la trop forte localisation, par le jeu de la relation de Heisenberg). Cette énergie admet un minimum pour une valeur de la distance entre électron et noyau égale à:

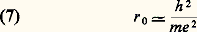

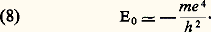

Conformément aux prévisions, cette quantité, nulle lorsque l’électron est indéfiniment éloigné du noyau, décroît ensuite et devient négative lorsqu’il se rapproche, mais se remet à croître indéfiniment lorsqu’il s’approche de trop près (croissance de l’énergie cinétique due à la trop forte localisation, par le jeu de la relation de Heisenberg). Cette énergie admet un minimum pour une valeur de la distance entre électron et noyau égale à: et est alors de l’ordre de:

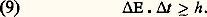

et est alors de l’ordre de: Naturellement, ces expressions n’ont qu’une valeur approchée et ne sont significatives qu’à un certain coefficient numérique près. Il est néanmoins très satisfaisant de constater que le rayon calculé suivant (7) est de l’ordre du dixième de nanomètre (10 size=1漣9 m) et l’énergie (8) de l’ordre de quelques électrons-volts. Ce sont bien là les valeurs expérimentales caractéristiques de l’atome d’hydrogène, et la démarche heuristique qui a abouti aux expressions (7) et (8) s’en trouve justifiée de même que la confiance en la possibilité d’une solution quantique rigoureuse du problème.En parfaite analogie avec la relation de Heisenberg «spatiale» (3), on établit une relation de Heisenberg «temporelle». On commence par noter, tout à fait classiquement, qu’un phénomène de durée t ne peut être qu’approximativement périodique et que sa fréquence 益 ne peut avoir une valeur bien déterminée; le phénomène possède nécessairement une certaine bande de fréquences de largeur 益, telle que t 練 益 礪黎 1. D’après la relation de Planck-Einstein (1), on en déduit que l’énergie du phénomène considéré possède une gamme de valeurs d’extension E, telle que:

Naturellement, ces expressions n’ont qu’une valeur approchée et ne sont significatives qu’à un certain coefficient numérique près. Il est néanmoins très satisfaisant de constater que le rayon calculé suivant (7) est de l’ordre du dixième de nanomètre (10 size=1漣9 m) et l’énergie (8) de l’ordre de quelques électrons-volts. Ce sont bien là les valeurs expérimentales caractéristiques de l’atome d’hydrogène, et la démarche heuristique qui a abouti aux expressions (7) et (8) s’en trouve justifiée de même que la confiance en la possibilité d’une solution quantique rigoureuse du problème.En parfaite analogie avec la relation de Heisenberg «spatiale» (3), on établit une relation de Heisenberg «temporelle». On commence par noter, tout à fait classiquement, qu’un phénomène de durée t ne peut être qu’approximativement périodique et que sa fréquence 益 ne peut avoir une valeur bien déterminée; le phénomène possède nécessairement une certaine bande de fréquences de largeur 益, telle que t 練 益 礪黎 1. D’après la relation de Planck-Einstein (1), on en déduit que l’énergie du phénomène considéré possède une gamme de valeurs d’extension E, telle que: En physique quantique, seuls peuvent donc avoir des énergies bien déterminées ( E = 0) des systèmes permanents dans des états invariables au cours du temps ( t = 秊); ce sont des états stationnaires . Inversement, des systèmes aux propriétés variables au cours du temps, dans des états non stationnaires, n’ont pas d’énergie bien déterminée. Ainsi les états instables de divers systèmes physiques possèdent-ils une largeur d’énergie naturelle minimale 嗀E, reliée à leur durée de vie 精 par la relation 嗀E 練 精 礪黎 h . Ces deux concepts, durée de vie et largeur de la bande d’énergie, sont absolument équivalents. Seule la pratique expérimentale entraîne l’utilisation prioritaire de l’un ou de l’autre. Ainsi les désintégrations par interactions faibles des particules fondamentales (par exemple, celle du méson 神, 神+猪+ + 益) ont-elles des temps caractéristiques – il s’agit des durées de vie des particules – directement mesurables ( 精 力 2,6 憐 10 size=1漣8 s, dans le cas cité), mais des largeurs très faibles ( 嗀E 力 2 憐 10 size=1漣14 MeV) par rapport à la masse (m 力 140 MeV du méson 神). Au contraire, pour les désintégrations dues aux interactions fortes (par exemple 福+神+ + 神0), c’est la largeur du spectre d’énergie, ou spectre de masse, que l’on mesure directement ( 嗀E 力 160 MeV), car la durée de vie correspondante ( 精 力 4 憐 10 size=1漣24 s) est beaucoup trop faible.3. Le formalisme général de la théorie quantiqueLa description qui suit du formalisme de la mécanique quantique a pour double but d’esquisser la conceptualisation mathématique qu’elle utilise et de montrer comment celle-ci rend compte des aspects heuristiques précédemment évoqués. Pour les raisons avancées en introduction, il ne s’agira ni d’une déduction formelle de la structure théorique ni d’une présentation didactique visant à rendre celle-ci immédiatement opérante. Il faut encore préciser qu’il s’agit ici d’un (plutôt que du ) formalisme de la théorie quantique. Celle-ci, comme toutes les théories physiques, est susceptible d’un certain polymorphisme mathématique et peut admettre des abstractions de divers niveaux. Entre les plus archaïques de ces formalismes (la mécanique ondulatoire ) et les plus modernes (fondés sur la théorie mathématique des algèbres stellaires ), on choisira un cours moyen, correspondant grosso modo à la pratique adoptée à l’heure actuelle par la majorité des théoriciens.La description théorique générale d’un système physique exige deux «règles de représentation » (on emploiera le mot «règle» à cause de sa neutralité épistémologique relative, pour éviter ici de soulever les problèmes qu’impliquerait le choix entre des termes comme «axiomes», «postulats», «lois», etc.). Il faut formaliser d’une part l’état physique du système, d’autre part ses propriétés , encore appelées «observables physiques», ou «variables dynamiques». En mécanique classique, il est habituel de décrire l’état d’un système par les positions et les vitesses des points matériels qui le constituent: c’est le formalisme lagrangien [cf. MÉCANIQUE ANALYTIQUE]. Les variables dynamiques, quant à elles (distance, quantité de mouvement, énergie, moment angulaire, etc.), sont des fonctions de ces positions et de ces vitesses. Une autre possibilité (formalisme hamiltonien ) consiste à adopter les positions et les quantités de mouvement comme paramètres descriptifs des états.En mécanique quantique, la situation est bien différente.Règle de représentation des états physiquesLes états d’un système physique sont décrits par les vecteurs unitaires d’un espace de Hilbert (ou espace vectoriel sur le corps des complexes, complet muni d’un produit scalaire, de norme associée définie positive). Cette règle formalise immédiatement le principe de superposition, par l’additivité (linéarité d’un espace vectoriel) qu’elle assure à l’ensemble des états d’un système: il existe une notion de somme de deux états d’un système dont le résultat est encore un état possible.Règle de représentation des propriétés physiquesLes observables physiques, ou variables dynamiques, d’un système sont décrites par des opérateurs linéaires auto-adjoints (hermitiques) agissant dans l’espace de Hilbert des états du système. Ce n’est pas le lieu de mentionner les subtiles difficultés mathématiques d’une telle définition, qui en exigent une certaine généralisation technique (problèmes du «spectre continu», extensions d’opérateurs, etc.). On remarquera seulement la modification radicale qu’elle implique des règles de la mécanique classique. Comme il a été dit, les concepts de position, de quantité de mouvement, etc., subsistent en mécanique quantique, mais avec une expression mathématique, et donc un sens physique profondément différent.Il faut encore introduire un élément essentiel, une règle de correspondance , qui, une fois connue la description théorique de l’état et des propriétés d’un système, permette, d’une part, d’établir le lien entre cette description et les résultats des mesures concrètes et, d’autre part, de représenter les expériences réelles auxquelles est soumis le système. Il s’agit de savoir ce que prédit la théorie pour valeur d’une variable dynamique donnée dans un certain état du système. En mécanique classique, cette règle est quasi évidente: la valeur (théorique) d’une variable dynamique, fonction des positions et des vitesses du système, est la valeur numérique que prend cette fonction pour les valeurs numériques des positions et des vitesses dans l’état du système. En mécanique quantique, les choses sont un peu plus compliquées. On rappellera tout d’abord, avant d’énoncer la règle, les notions de valeurs propres et de vecteurs propres d’un opérateur auto-adjoint A dans un espace de Hilbert 流. Un «vecteur propre» 﨏a 捻 流 de A, correspondant à la «valeur propre» a , est défini par la propriété:

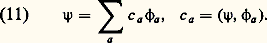

En physique quantique, seuls peuvent donc avoir des énergies bien déterminées ( E = 0) des systèmes permanents dans des états invariables au cours du temps ( t = 秊); ce sont des états stationnaires . Inversement, des systèmes aux propriétés variables au cours du temps, dans des états non stationnaires, n’ont pas d’énergie bien déterminée. Ainsi les états instables de divers systèmes physiques possèdent-ils une largeur d’énergie naturelle minimale 嗀E, reliée à leur durée de vie 精 par la relation 嗀E 練 精 礪黎 h . Ces deux concepts, durée de vie et largeur de la bande d’énergie, sont absolument équivalents. Seule la pratique expérimentale entraîne l’utilisation prioritaire de l’un ou de l’autre. Ainsi les désintégrations par interactions faibles des particules fondamentales (par exemple, celle du méson 神, 神+猪+ + 益) ont-elles des temps caractéristiques – il s’agit des durées de vie des particules – directement mesurables ( 精 力 2,6 憐 10 size=1漣8 s, dans le cas cité), mais des largeurs très faibles ( 嗀E 力 2 憐 10 size=1漣14 MeV) par rapport à la masse (m 力 140 MeV du méson 神). Au contraire, pour les désintégrations dues aux interactions fortes (par exemple 福+神+ + 神0), c’est la largeur du spectre d’énergie, ou spectre de masse, que l’on mesure directement ( 嗀E 力 160 MeV), car la durée de vie correspondante ( 精 力 4 憐 10 size=1漣24 s) est beaucoup trop faible.3. Le formalisme général de la théorie quantiqueLa description qui suit du formalisme de la mécanique quantique a pour double but d’esquisser la conceptualisation mathématique qu’elle utilise et de montrer comment celle-ci rend compte des aspects heuristiques précédemment évoqués. Pour les raisons avancées en introduction, il ne s’agira ni d’une déduction formelle de la structure théorique ni d’une présentation didactique visant à rendre celle-ci immédiatement opérante. Il faut encore préciser qu’il s’agit ici d’un (plutôt que du ) formalisme de la théorie quantique. Celle-ci, comme toutes les théories physiques, est susceptible d’un certain polymorphisme mathématique et peut admettre des abstractions de divers niveaux. Entre les plus archaïques de ces formalismes (la mécanique ondulatoire ) et les plus modernes (fondés sur la théorie mathématique des algèbres stellaires ), on choisira un cours moyen, correspondant grosso modo à la pratique adoptée à l’heure actuelle par la majorité des théoriciens.La description théorique générale d’un système physique exige deux «règles de représentation » (on emploiera le mot «règle» à cause de sa neutralité épistémologique relative, pour éviter ici de soulever les problèmes qu’impliquerait le choix entre des termes comme «axiomes», «postulats», «lois», etc.). Il faut formaliser d’une part l’état physique du système, d’autre part ses propriétés , encore appelées «observables physiques», ou «variables dynamiques». En mécanique classique, il est habituel de décrire l’état d’un système par les positions et les vitesses des points matériels qui le constituent: c’est le formalisme lagrangien [cf. MÉCANIQUE ANALYTIQUE]. Les variables dynamiques, quant à elles (distance, quantité de mouvement, énergie, moment angulaire, etc.), sont des fonctions de ces positions et de ces vitesses. Une autre possibilité (formalisme hamiltonien ) consiste à adopter les positions et les quantités de mouvement comme paramètres descriptifs des états.En mécanique quantique, la situation est bien différente.Règle de représentation des états physiquesLes états d’un système physique sont décrits par les vecteurs unitaires d’un espace de Hilbert (ou espace vectoriel sur le corps des complexes, complet muni d’un produit scalaire, de norme associée définie positive). Cette règle formalise immédiatement le principe de superposition, par l’additivité (linéarité d’un espace vectoriel) qu’elle assure à l’ensemble des états d’un système: il existe une notion de somme de deux états d’un système dont le résultat est encore un état possible.Règle de représentation des propriétés physiquesLes observables physiques, ou variables dynamiques, d’un système sont décrites par des opérateurs linéaires auto-adjoints (hermitiques) agissant dans l’espace de Hilbert des états du système. Ce n’est pas le lieu de mentionner les subtiles difficultés mathématiques d’une telle définition, qui en exigent une certaine généralisation technique (problèmes du «spectre continu», extensions d’opérateurs, etc.). On remarquera seulement la modification radicale qu’elle implique des règles de la mécanique classique. Comme il a été dit, les concepts de position, de quantité de mouvement, etc., subsistent en mécanique quantique, mais avec une expression mathématique, et donc un sens physique profondément différent.Il faut encore introduire un élément essentiel, une règle de correspondance , qui, une fois connue la description théorique de l’état et des propriétés d’un système, permette, d’une part, d’établir le lien entre cette description et les résultats des mesures concrètes et, d’autre part, de représenter les expériences réelles auxquelles est soumis le système. Il s’agit de savoir ce que prédit la théorie pour valeur d’une variable dynamique donnée dans un certain état du système. En mécanique classique, cette règle est quasi évidente: la valeur (théorique) d’une variable dynamique, fonction des positions et des vitesses du système, est la valeur numérique que prend cette fonction pour les valeurs numériques des positions et des vitesses dans l’état du système. En mécanique quantique, les choses sont un peu plus compliquées. On rappellera tout d’abord, avant d’énoncer la règle, les notions de valeurs propres et de vecteurs propres d’un opérateur auto-adjoint A dans un espace de Hilbert 流. Un «vecteur propre» 﨏a 捻 流 de A, correspondant à la «valeur propre» a , est défini par la propriété: Autrement dit, l’action de l’opérateur sur un de ses vecteurs propres revient à le multiplier par la valeur propre correspondante. Les valeurs propres d’un opérateur auto-adjoint sont des nombres réels. L’ensemble des valeurs propres d’un opérateur est appelé son «spectre». Celui-ci peut être discret (composé de valeurs propres dénombrables, séparées), ou continu (il convient dans ce cas de raffiner quelque peu le formalisme mathématique), ou encore il peut comporter une partie discrète et une partie continue. L’importance, plus pratique que fondamentale, des opérateurs auto-adjoints en théorie quantique, ne tient pas tant à la réalité de leur spectre qu’aux propriétés de leurs vecteurs propres. En effet, l’ensemble des vecteurs propres 﨏a d’un opérateur A auto-adjoint forme, une fois ces vecteurs normalisés, une base orthonormée, et n’importe quel vecteur 祥 de l’espace de Hilbert s’exprimera donc sous la forme d’une combinaison linéaire de ces vecteurs de base, avec pour coefficients ses projections sur ces vecteurs, c’est-à-dire les produits scalaires correspondants; en d’autres termes:

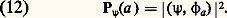

Autrement dit, l’action de l’opérateur sur un de ses vecteurs propres revient à le multiplier par la valeur propre correspondante. Les valeurs propres d’un opérateur auto-adjoint sont des nombres réels. L’ensemble des valeurs propres d’un opérateur est appelé son «spectre». Celui-ci peut être discret (composé de valeurs propres dénombrables, séparées), ou continu (il convient dans ce cas de raffiner quelque peu le formalisme mathématique), ou encore il peut comporter une partie discrète et une partie continue. L’importance, plus pratique que fondamentale, des opérateurs auto-adjoints en théorie quantique, ne tient pas tant à la réalité de leur spectre qu’aux propriétés de leurs vecteurs propres. En effet, l’ensemble des vecteurs propres 﨏a d’un opérateur A auto-adjoint forme, une fois ces vecteurs normalisés, une base orthonormée, et n’importe quel vecteur 祥 de l’espace de Hilbert s’exprimera donc sous la forme d’une combinaison linéaire de ces vecteurs de base, avec pour coefficients ses projections sur ces vecteurs, c’est-à-dire les produits scalaires correspondants; en d’autres termes: Règle de correspondancea ) Les valeurs possibles d’une propriété physique, représentée par un opérateur auto-adjoint A, sont les valeurs propresa de cet opérateur.b ) La mesure de la propriété représentée par l’opérateur A sur un système dans l’état représenté par le vecteur unitaire 祥 fournit l’une quelconque des valeurs propres a de A avec une probabilité:

Règle de correspondancea ) Les valeurs possibles d’une propriété physique, représentée par un opérateur auto-adjoint A, sont les valeurs propresa de cet opérateur.b ) La mesure de la propriété représentée par l’opérateur A sur un système dans l’état représenté par le vecteur unitaire 祥 fournit l’une quelconque des valeurs propres a de A avec une probabilité: On voit apparaître ici les amplitudes de probabilité déjà mentionnées.On reprendra l’exemple de l’expérience des trous d’Young pour illustrer le formalisme introduit ci-dessus. Cette expérience peut être conçue comme une mesure de la position d’arrivée des particules sur l’écran. À cette propriété observable (la position) correspond un certain opérateur auto-adjoint X, dont le spectre est continu et comprend toutes les valeurs numériques possibles de position sur l’écran. À chaque valeur propre x correspond un vecteur propre 﨏x tel que X 﨏x = x 﨏x qui représente l’état physique d’une particule exactement localisée au point x . Si l’on appelle 祥1 le vecteur d’état d’une particule lorsque le trou 1 est seul ouvert, l’amplitude de probabilité de la recevoir sur l’écran au point x s’écrit alors, d’après la relation (12), f 1(x ) = ( 祥1, 﨏x ). De même, lorsque le trou 2 est seul ouvert, on a f 2(x ) = ( 祥2, 﨏x ). Enfin, si les deux trous sont ouverts, l’état de l’électron est représenté, d’après le principe de superposition, par le vecteur 祥1,2 = 祥1 + 祥2, de sorte que l’amplitude de probabilité f 1,2 = ( 祥1,2, 﨏x ) est bien la somme des deux amplitudes f 1(x ) et f 2(x ).On peut comprendre maintenant l’origine précise des relations de Heisenberg et faire le lien entre le formalisme rigoureux décrit ici et l’approche heuristique utilisée plus haut. En effet, il découle de la règle de correspondance qu’un système physique ayant pour vecteur d’état un vecteur propre d’un certain opérateur A est caractérisé par une valeur numérique déterminée de l’observable en question (la valeur propre correspondante): la probabilité calculée suivant la relation (12) est égale à 1 pour cette valeur et à 0 pour toutes les autres. Il en résulte qu’un système physique, pour pouvoir être caractérisé par des valeurs bien déterminées de plusieurs observables, doit posséder un vecteur d’état qui soit simultanément vecteur propre des différents opérateurs correspondants. Cela n’est guère possible en général, chaque opérateur ayant son propre jeu de vecteurs propres. On montre que deux opérateurs ont les mêmes vecteurs propres si, et seulement si, ils «commutent», c’est-à-dire si l’on obtient le même résultat, quel que soit l’ordre dans lequel on les applique à un vecteur de l’espace de Hilbert. On est ainsi amené à définir le commutateur de deux opérateurs quelconques A et B:

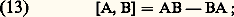

On voit apparaître ici les amplitudes de probabilité déjà mentionnées.On reprendra l’exemple de l’expérience des trous d’Young pour illustrer le formalisme introduit ci-dessus. Cette expérience peut être conçue comme une mesure de la position d’arrivée des particules sur l’écran. À cette propriété observable (la position) correspond un certain opérateur auto-adjoint X, dont le spectre est continu et comprend toutes les valeurs numériques possibles de position sur l’écran. À chaque valeur propre x correspond un vecteur propre 﨏x tel que X 﨏x = x 﨏x qui représente l’état physique d’une particule exactement localisée au point x . Si l’on appelle 祥1 le vecteur d’état d’une particule lorsque le trou 1 est seul ouvert, l’amplitude de probabilité de la recevoir sur l’écran au point x s’écrit alors, d’après la relation (12), f 1(x ) = ( 祥1, 﨏x ). De même, lorsque le trou 2 est seul ouvert, on a f 2(x ) = ( 祥2, 﨏x ). Enfin, si les deux trous sont ouverts, l’état de l’électron est représenté, d’après le principe de superposition, par le vecteur 祥1,2 = 祥1 + 祥2, de sorte que l’amplitude de probabilité f 1,2 = ( 祥1,2, 﨏x ) est bien la somme des deux amplitudes f 1(x ) et f 2(x ).On peut comprendre maintenant l’origine précise des relations de Heisenberg et faire le lien entre le formalisme rigoureux décrit ici et l’approche heuristique utilisée plus haut. En effet, il découle de la règle de correspondance qu’un système physique ayant pour vecteur d’état un vecteur propre d’un certain opérateur A est caractérisé par une valeur numérique déterminée de l’observable en question (la valeur propre correspondante): la probabilité calculée suivant la relation (12) est égale à 1 pour cette valeur et à 0 pour toutes les autres. Il en résulte qu’un système physique, pour pouvoir être caractérisé par des valeurs bien déterminées de plusieurs observables, doit posséder un vecteur d’état qui soit simultanément vecteur propre des différents opérateurs correspondants. Cela n’est guère possible en général, chaque opérateur ayant son propre jeu de vecteurs propres. On montre que deux opérateurs ont les mêmes vecteurs propres si, et seulement si, ils «commutent», c’est-à-dire si l’on obtient le même résultat, quel que soit l’ordre dans lequel on les applique à un vecteur de l’espace de Hilbert. On est ainsi amené à définir le commutateur de deux opérateurs quelconques A et B: si ce commutateur est nul, les deux observables correspondant à A et à B pourront simultanément prendre des valeurs bien déterminées. Mais il n’existe, pour tout système physique, qu’un nombre limité de tels opérateurs qui commutent (non uniquement défini d’ailleurs). On ne doit donc pas s’attendre que puissent être simultanément déterminées toutes les observables d’intérêt. C’est le cas, en particulier, des observables de position X et de quantité de mouvement P qui obéissent à la relation de commutation canonique :

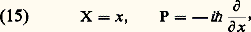

si ce commutateur est nul, les deux observables correspondant à A et à B pourront simultanément prendre des valeurs bien déterminées. Mais il n’existe, pour tout système physique, qu’un nombre limité de tels opérateurs qui commutent (non uniquement défini d’ailleurs). On ne doit donc pas s’attendre que puissent être simultanément déterminées toutes les observables d’intérêt. C’est le cas, en particulier, des observables de position X et de quantité de mouvement P qui obéissent à la relation de commutation canonique : où I est l’opérateur identité et 寮 = h /2 神 une constante de Planck redéfinie, souvent plus commode à utiliser que h elle-même. Grâce à cette relation (dont on examinera l’origine plus loin: cf. chap. 4), on démontre rigoureusement la relation de Heisenberg (3). Celle-ci exprime bien l’impossibilité d’états physiques simultanément définis en position et en quantité de mouvement. Elle repose, on le voit ici, sur la nature profonde des concepts quantiques de position et de quantité de mouvement.Dans la pratique, on repère les états d’un système physique par rapport à une base de l’espace de Hilbert formée de vecteurs propres communs à un certain ensemble d’opérateurs, commutant entre eux et choisis pour leur intérêt physique. Parmi eux figure presque toujours l’opérateur d’énergie, ou hamiltonien. En effet, on a déjà vu, en étudiant la relation de Heisenberg temporelle (9), que les états stationnaires d’un système physique sont les états d’énergie bien définis, c’est-à-dire les états propres de l’opérateur correspondant. Le calcul des énergies possibles d’un système, ou valeurs propres de l’opérateur d’énergie (on dit la «diagonalisation» de cet opérateur), constitue le moment principal de toute une classe de problèmes quantiques. Ainsi le calcul théorique des fréquences des raies d’émission lumineuse des atomes, ou théorie de la spectroscopie atomique, repose-t-il sur le calcul des niveaux d’énergie des atomes [cf. SPECTROSCOPIE]. Le spectre d’énergie d’un système physique constitue souvent un bon exemple de spectre mixte, comportant une partie discrète et une partie continue. Quand il existe, le spectre discret (niveaux d’énergie séparés, dénombrables) correspond aux états liés du système physique, ceux où ses divers constituants restent groupés sous l’effet de forces attractives. Le spectre continu, lui, correspond aux états de diffusion , qui décrivent l’interaction entre deux systèmes se rapprochant depuis une distance infinie puis s’éloignant à nouveau: c’est le type d’expérience pratiqué à l’aide d’accélérateurs de particules, par exemple.4. Du principe de compatibilité aux principes de symétrieFrontière entre classique et quantiqueAprès cette description générale du formalisme quantique, valable pour un système physique quelconque, il reste à concrétiser cette structure, c’est-à-dire à la réaliser pour tel ou tel cas particulier. Plus précisément, le problème est de savoir sur quelles bases établir la réalisation pratique de la théorie pour un système physique donné, en particulier par quel opérateur représenter telle observable physique.Cette question a été abordée dès les débuts de la théorie quantique à l’aide d’un «principe de correspondance», que l’on préférera appeler ici principe de compatibilité . Il s’agit d’une exigence de cohérence élémentaire: à la limite où les effets quantiques deviennent négligeables (par exemple quand la valeur numérique de 寮 est très petite comparée aux ordres de grandeur du système considéré), les prédictions de la mécanique quantique doivent coïncider avec celles de la mécanique classique. Ce principe est une sorte de condition aux limites qu’il est tout naturel d’imposer à la théorie quantique et qu’il est assez normal d’utiliser comme guide au passage de la frontière entre classique et quantique. La fécondité de ce point de vue a d’ailleurs été étonnante. Sous une forme d’abord plutôt vague et heuristique, c’est bien ce «principe de compatibilité» que Bohr utilisa pour formuler son fameux modèle de l’atome d’hydrogène (1913). Après de multiples raffinements, le principe de compatibilité fut formalisé par Dirac sous la forme d’une règle de comparaison entre la mécanique classique en formalisme hamiltonien et la mécanique quantique. Suivant cette règle, les crochets de Poisson [cf. MÉCANIQUE ANALYTIQUE] de la mécanique classique correspondent aux commutateurs de la mécanique quantique; si, classiquement, on a 遼, 龍 = 暈 pour trois observables (classiques) 遼, 龍 et 暈, les opérateurs quantiques A, B et C correspondants obéissent à [A, B] = i 寮 C. On justifie ainsi la relation de commutation canonique (14) sur la base de son homologue classique, le crochet de Poisson canonique: face=F0019 栗, 戮 = 1.S’il a joué un rôle historique décisif, le principe de compatibilité présente néanmoins de graves limitations. Il est tout d’abord épistémologiquement peu satisfaisant de fonder le détail de la structure de la mécanique quantique sur celle de la mécanique classique, dans la mesure où cette dernière n’est conçue que comme une approximation de la première. Sur le plan pratique ensuite, le principe de compatibilité ne permet la construction que des seules observables quantiques qui ont un analogue (une limite) classique. Des propriétés spécifiquement quantiques, ne donnant pas lieu à effets classiques, ne pourront qu’être ignorées dans une telle approche: c’est le cas, par exemple, du spin , ou moment angulaire intrinsèque des particules.Principes de symétrieIl est possible, en fait, de se passer du principe de compatibilité pour la réalisation concrète des théories quantiques. Son rôle est avantageusement remplacé par celui que jouent aujourd’hui les principes de symétrie . L’importance de ces derniers n’a fait que croître au cours des développements de la physique théorique moderne.L’existence de propriétés très générales de symétrie (dites encore d’invariance ) des phénomènes physiques a, en effet, des conséquences particulièrement importantes en physique quantique. Il s’agit principalement ici des symétries spatio-temporelles: les lois auxquelles obéit un système physique isolé gardent la même forme lorsque ce système subit une translation spatiale, une rotation spatiale, une évolution au cours du temps ou une mise en mouvement uniforme (principe de relativité ). Ces diverses opérations forment un groupe de transformation (cf. GROUPES [mathématiques]): il s’agit, en fait, du groupe de Poincaré, mais on utilise souvent son approximation «non relativiste», le groupe de Galilée. En mécanique quantique, l’invariance des lois régissant un certain système physique sous une transformation d’un groupe de symétrie exige l’invariance des probabilités, telles que les donne la relation (12), qui régissent les prédictions théoriques. Un théorème fondamental, dû à Wigner, assure alors que l’effet de la transformation en question sur le système est donné par l’action, dans l’espace de Hilbert des états, d’un opérateur unitaire associé à la transformation. La loi de groupe, qui régit la composition des diverses transformations, entraîne alors que les opérateurs unitaires qui leur sont associés forment une représentation (unitaire ) du groupe . Si ce groupe est continu, et plus précisément s’il est un groupe de Lie, il peut être étudié par des méthodes infinitésimales (cf. GROUPES – Groupes de Lie). On considère alors son algèbre de Lie, qui est représentée dans l’espace de Hilbert des états par une algèbre d’opérateurs auto-adjoints: ce sont les générateurs infinitésimaux de la représentation du groupe. Ces opérateurs sont étroitement associés à ceux qui correspondent aux observables physiques. Ainsi l’invariance par translation spatiale a-t-elle pour générateurs infinitésimaux les opérateurs de quantité de mouvement. De même l’énergie se trouve-t-elle associée à l’évolution temporelle, le moment angulaire aux rotations et la position aux transformations de Galilée ou de Lorentz (mise en mouvement uniforme). Les relations de commutation fondamentales entre les opérateurs représentant les observables physiques reflètent donc simplement les propriétés d’invariance spatio-temporelles. Ainsi la relation de commutation canonique (14) exprime-t-elle l’exigence que l’opérateur de position X se transforme correctement lors d’une translation spatiale, dont l’opérateur de quantité de mouvement P est le générateur infinitésimal.Parmi ces divers générateurs infinitésimaux, une importance toute particulière est dévolue à l’opérateur d’énergie, ou hamiltonien [cf. MÉCANIQUE ANALYTIQUE]. Générateur de l’évolution temporelle, c’est lui qui gouverne la dynamique du système considéré. Dans l’expression du hamiltonien apparaissent les propriétés caractéristiques des forces et des interactions qui régissent le système physique. En mécanique quantique non relativiste, ces forces sont symbolisables par un potentiel d’interaction , donnant à l’énergie une expression formellement identique à celle de la mécanique classique, somme d’un terme cinétique (fonction des quantités de mouvement) et d’un terme potentiel (fonction des positions); mais il s’agit ici de grandeurs opératorielles. On appelle communément équation de Schrödinger [cf. ATOME] cette expression du hamiltonien d’un système de particules quantiques non relativistes. La «résolution» de cette équation n’est autre que la diagonalisation du hamiltonien et fournit les énergies et les vecteurs d’état des états stationnaires. Cette diagonalisation est souvent facilitée par la diagonalisation simultanée d’observables physiques commutant avec le hamiltonien et ayant donc les mêmes vecteurs propres que lui. Ces observables ont d’ailleurs un sens physique très important: puisque le hamiltonien, générateur de l’évolution temporelle, commute avec elles, elles ne sont pas affectées par l’écoulement du temps et restent invariantes. Elles obéissent donc à des lois de conservation . Plus précisément, un état propre de telles observables le reste au cours du temps avec une valeur propre (valeur numérique de la grandeur physique correspondante) constante. Un exemple intéressant est celui de forces centrales, où la symétrie sphérique du problème (invariance par rapport au groupe des rotations spatiales) entraîne la conservation du moment cinétique (générateur infinitésimal de ce même groupe) par rapport au centre de forces. La diagonalisation de telles observables permet une diagonalisation partielle du hamiltonien en séparant l’espace de Hilbert des états en sous-espaces invariants plus petits; elle fournit de plus un repérage des états stationnaires au moyen de paramètres (les valeurs propres des observables invariantes) à la signification physique importante. Il reste à préciser qu’il n’est pas toujours commode de travailler à l’aide de la seule structure abstraite de l’algèbre des observables, en n’utilisant que leurs relations de commutation. Pour la plupart des problèmes complexes de physique atomique par exemple, on utilise une réalisation particulière de cette structure. On y choisit pour espace de Hilbert un espace de fonctions de carré sommable, et les opérateurs canoniques de position et de quantité de mouvement sont réalisés comme opérateurs de multiplication et de dérivation respectivement: